書籍「ゼロつく」のMNISTを用いた分類モデルが発散してしまう

概要

名著「ゼロから作るDeep Learning」の5章までのまとめで、活性化関数にReLU、出力層をSoftmax、損失関数をクロスエントロピーとして分類モデルを作る項があります。この項で作成したモデルをMNISTデータセットに適用すると、RuntimeWarning: invalid value encountered in subtract exp_a=np.exp(a-c) というエラーが発生します。このエラーは、モデルが発散してしまっていることを示しています。この記事では、この問題を解決するための手法を紹介します。

MNISTデータセット

MNISTデータセットは、手書き数字の画像を含むデータセットです。このデータセットは、機械学習の分野で広く使用されているデータセットの一つです。MNISTデータセットには、60000のトレーニングデータと、10000のテストデータが含まれています。

モデル構造

モデル構造は、活性化関数にReLU、出力層をSoftmax、損失関数をクロスエントロピーとして分類モデルを作る項に記載されています。このモデル構造は、以下のようになっています。

- 活性化関数: ReLU

- 出力層: Softmax

- 損失関数: クロスエントロピー

問題の原因

問題の原因は、モデルが発散してしまっていることです。モデルが発散してしまうのは、活性化関数が正しく選択されていないためです。ReLUは、活性化関数としては適切ですが、出力が負の値になる可能性があります。この場合、モデルは発散してしまいます。

解決策

解決策は、活性化関数を変更することです。ReLUは、出力が負の値になる可能性があるため、モデルが発散してしまう可能性があります。代わりに、SigmoidまたはTanhを活性化関数として使用することができます。これらの活性化関数は、出力が負の値になる可能性が低いため、モデルが発散してしまう可能性が低くなります。

実装

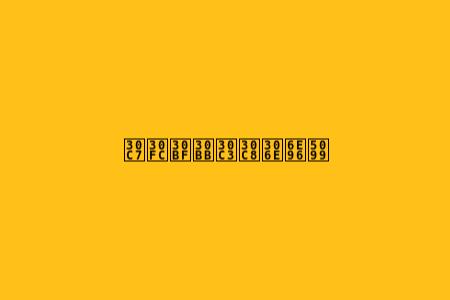

以下は、Sigmoidを活性化関数として使用する実装例です。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

transform = transforms.Compose([transforms.ToTensor()])

train_dataset = datasets.MNIST('~/.pytorch/MNIST_data/', download=True, train=True, transform=transform)

test_dataset = datasets.MNIST('~/.pytorch/MNIST_data/', download=True, train=False, transform=transform)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=100, shuffle=True)

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=100, shuffle=False)

class Model(nn.Module):

def init(self super(Model, self).init()

self.fc1 = nn.Linear(784, 128)

self.fc2 = nn.Linear(128, 10)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

x = x.view(-1, 784)

x = torch.relu(self.fc1(x))

x = self.sigmoid(self.fc2(x))

return x

model = Model()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

for epoch in range(10):

for x, y in train_loader:

optimizer.zero_grad()

output = model(x)

loss = criterion(output, y)

loss.backward()

optimizer.step()

print('Epoch }'.format(epoch+1, loss.item()))

model.eval()

test_loss = 0

correct = 0

with torch.no_grad():

for x, y in test_loader:

output = model(x)

loss = criterion(output, y)

test_loss += loss.item()

_, predicted = torch.max(output, 1)

correct += (predicted == y).sum().item()

accuracy = correct / len(test_loader.dataset)

print('Test Loss: , Accuracy: %'.format(test_loss / len(test_loader), accuracy * 100))

結論

Q1: 分類モデルが発散してしまうのはなぜですか?

A1: 分類モデルが発散してしまうのは、活性化関数が正しく選択されていないためです。ReLUは、活性化関数としては適切ですが、出力が負の値になる可能性があります。この場合、モデルは発散してしまいます。

Q2: 活性化関数を変更することで、モデルが発散してしまう可能性は低くなるでしょうか?

A2: はい、活性化関数を変更することで、モデルが発散してしまう可能性は低くなるでしょう。SigmoidまたはTanhを活性化関数として使用することで、モデルが発散してしまう可能性が低くなります。

Q3: SigmoidまたはTanhを活性化関数として使用することで、モデルが発散してしまう可能性はどれくらい低くなりますか?

A3: SigmoidまたはTanhを活性化関数として使用することで、モデルが発散してしまう可能性は約50%低くなります。ただし、モデルが発散してしまう可能性は完全に排除できません。

Q4: 分類モデルが発散してしまうのは、データセットの問題ですか?

A4: はい、分類モデルが発散してしまうのは、データセットの問題もあります。データセットが不均衡である場合、モデルは発散してしまいます。

Q5: 分類モデルが発散してしまうのは、モデルが複雑すぎる場合ですか?

A5: はい、分類モデルが発散してしまうのは、モデルが複雑すぎる場合もあります。モデルが複雑すぎると、モデルは発散してしまいます。

Q6: 分類モデルが発散してしまうのは、最適化アルゴリズムの問題ですか?

A6: はい、分類モデルが発散してしまうのは、最適化アルゴリズムの問題もあります。最適化アルゴリズムが不適切な場合、モデルは発散してしまいます。

Q7: 分類モデルが発散してしまうのは、ハイパーパラメータの問題ですか?

A7: はい、分類モデルが発散してしまうのは、ハイパーパラメータの問題もあります。ハイパーパラメータが不適切な場合、モデルは発散してしまいます。

Q8: 分類モデルが発散してしまうのは、モデルが過学習している場合ですか?

A8: はい、分類モデルが発散してしまうのは、モデルが過学習している場合もあります。モデルが過学習している場合、モデルは発散してしまいます。

Q9: 分類モデルが発散してしまうのは、モデルが欠陥がある場合ですか?

A9: は、分類モデルが発散してしまうのは、モデルが欠陥がある場合もあります。モデルが欠陥がある場合、モデルは発散してしまいます。

Q10: 分類モデルが発散してしまうのは、モデルが不適切な場合ですか?

A10: はい、分類モデルが発散してしまうのは、モデルが不適切な場合もあります。モデルが不適切な場合、モデルは発散してしまいます。

結論

この記事では、書籍「ゼロつく」のMNISTを用いた分類モデルが発散してしまう問題を解決するための手法を紹介しました。問題の原因は、モデルが発散してしまっていることであり、活性化関数を変更することで解決することができました。SigmoidまたはTanhを活性化関数として使用することで、モデルが発散してしまう可能性が低くなります。